近年、ChatGPTをはじめとする生成AI技術が急速に進化し、私たちの働き方や創造性を大きく変えようとしています。その中でも特に注目を集めているのが、Googleが開発した最先端AIモデルファミリー「Gemini」と、その能力を開発者が利用できるようにする「Gemini API」です。

「Gemini APIって何?」「何ができるの?」「どうやって使うの?」「料金は?」

この記事では、そんな疑問をお持ちの方に向けて、Gemini APIの全貌を徹底解説します。基本的な概念から、具体的な使い方、料金体系、さらには他のAI APIとの比較まで、最新情報(2025年4月時点)を盛り込み、Gemini APIを最大限に活用するための知識を網羅的にお届けします。

この記事でわかること:

- GeminiおよびGemini APIの基本的な定義と目的

- Geminiモデルファミリー(Pro, Flash, Nano)の種類と特徴

- Gemini APIで実現できる多彩な機能(マルチモーダル処理、画像・動画生成、コード実行など)

- Gemini APIの導入方法と開発手順(Google AI StudioとVertex AIの違いを含む)

- 最新の料金体系と無料枠、コスト削減のヒント

- 他の主要AI API(例: OpenAI API)との比較とGemini APIの強み

1. Geminiとは? - Google AIの中核をなすモデルファミリー

まず、「Gemini API」を理解する上で欠かせないのが、その基盤となるAIモデル「Gemini」です。

Geminiの基本概念:マルチモーダルAIとは?

Geminiは、Google DeepMindによって開発された、Googleの最新かつ最も高性能な生成AIモデル群の総称です。単一のモデルではなく、テキスト、画像、音声、動画、コードといった多様なモダリティ(情報の種類)をゼロから理解し、シームレスに組み合わせて推論できるように設計されています。これがGeminiの最大の特徴である「ネイティブなマルチモーダル性」です。

従来のAIモデルの多くは、テキストならテキスト、画像なら画像と、特定の種類の情報処理に特化していました。しかしGeminiは、例えば「この画像に写っているイベントについて説明するブログ記事を書いて」といった、複数の種類の情報を組み合わせた複雑な指示も理解し、実行できます。

Geminiモデルの種類と特徴 (Pro, Flash, Nano)

Geminiは、用途や性能要件に応じて最適化された複数のモデルバリアント(モデルファミリー)を提供しています。Googleは継続的にモデル開発を進めており、新しいバージョンや機能強化版が次々と登場しています。

主要なモデルと最新の注目モデル(2025年4月時点)を見てみましょう。

- Gemini Proシリーズ (例: 1.5 Pro, 2.5 Pro):

- 高度な能力とコスト効率のバランスが取れた主力モデル。

- 特にGemini 2.5 Proは、強力な推論能力、コーディング能力、そして100万トークン(最大200万トークンをテスト中 )という驚異的な長文コンテキストウィンドウを備えた「思考モデル(Thinking Model)」として位置づけられています 。複雑な問題に対して、人間のように段階的に思考プロセスを経て回答を生成しようとします 。

- Gemini Flashシリーズ (例: 1.5 Flash, 2.0 Flash, 2.0 Flash-Lite, 2.5 Flash):

- 速度とコスト効率に最適化されており、高頻度のタスクや低レイテンシが要求されるアプリケーションに適しています 。

- Gemini 2.0 Flashは、リアルタイムストリーミングAPI(Live API)にも対応し 、Gemini 2.0 Flash-Liteは最もコスト効率が良い選択肢です 。

- Gemini 2.5 Flashも登場し、思考モデルの能力をより高速・低コストで利用可能にしています 。

- Gemini Nanoシリーズ (例: Nano 1, Nano 2):

- スマートフォンなどのオンデバイスでの実行に特化して設計されています。

- Google AI Edgeプラットフォームを通じて利用可能で、低レイテンシ、オフライン機能、データプライバシーの向上といった利点があります 。最新のNano 2は、前世代よりも大幅に性能が向上しています 。

表1: Gemini 主要モデル比較 (2025年4月時点)

| モデル名 (例) | 主な強み | 最大入力コンテキスト (トークン) | 主なアクセスプラットフォーム |

| Gemini 2.5 Pro (Preview) | 最高レベルの推論・コーディング、思考モデル、超長文脈 (100万トークン) | 1,048,576 | Vertex AI, Google AI Studio (SDK経由) |

| Gemini 2.5 Flash (Preview) | 高速な推論、思考モデル、長文脈、コスト効率 | 1,048,576 | Vertex AI, Google AI Studio (SDK経由) |

| Gemini 2.0 Flash | 速度、コスト効率、リアルタイム性 (Live API対応) | 1,048,576 | Vertex AI, Google AI Studio |

| Gemini 2.0 Flash-Lite | 最速、最もコスト効率が良い、高頻度タスク | 1,048,576 | Vertex AI, Google AI Studio |

| Gemini Nano (例: Nano 2) | オンデバイス実行、低レイテンシ、プライバシー | (デバイス依存) | Google AI Edge (Android) |

(注: 上記は代表的なモデルの概要です。バージョンや提供状況、機能サポートは急速に変化します。最新情報は公式ドキュメント を参照してください。)

他のAIモデルとの違い

Geminiファミリー、特に最新モデルは、以下の点で他の主要なAIモデル(例: OpenAIのGPTシリーズ、AnthropicのClaudeシリーズ)と差別化を図っています。

- ネイティブなマルチモーダル性: 設計当初から多様なモダリティを統合的に扱えるように作られています。

- 圧倒的な長文コンテキストウィンドウ: 最大100万〜200万トークンというコンテキスト長は、現時点で他の追随を許さないレベルです 。これにより、非常に長い文書やコード、動画全体の分析が可能になります。

- Googleエコシステムとの強力な連携: Google検索(Grounding)、Google Cloud (Vertex AI)、Firebase、Workspaceなど、Googleのサービス群とのシームレスな統合が可能です。

- 思考モデル (Thinking Mode): 応答前に内部的な思考プロセスを経ることで、複雑な問題解決能力を高めています 。

- オンデバイス実行 (Nano): スマートフォン等でローカルにAIを実行できる選択肢を提供します。

2. Gemini APIでできること - 主要機能と活用例

では、Gemini APIを使うと具体的にどのようなことができるのでしょうか?その多彩な機能と活用例を見ていきましょう。

テキスト生成・要約・分類

最も基本的な機能として、ブログ記事、メール、広告コピー、コード、詩など、様々な種類のテキストコンテンツを生成できます。また、長文のドキュメントや記事を要約したり、テキストの内容に基づいて分類したりすることも可能です。

マルチモーダルな情報処理

Gemini APIの真骨頂は、テキスト、画像、音声、動画、PDFといった異なる種類の情報を組み合わせて処理できる点です。

- 画像理解: 画像の内容説明、画像内のテキスト抽出(OCR)、画像に関する質疑応答などが可能です。

- 動画・音声理解: 動画の内容に基づいた要約生成、トランスクリプト作成、音声からの情報抽出などが行えます。

- PDF処理: PDFドキュメントの内容を理解し、情報を抽出したり要約したりできます。

これにより、「この製品紹介動画を見て、特徴をまとめた上で、販促用のSNS投稿文を3パターン作成して」といった、複数のモダリティを横断する複雑なタスクを実現できます。

画像・動画生成 (Imagen, Veo連携)

Gemini APIは、情報の理解・分析だけでなく、メディア生成機能も統合しています。

- 画像生成 (Imagen): Googleの高品質画像生成モデル「Imagen」と連携し、テキストプロンプトに基づいて文脈に合った画像をAPI経由で生成・編集できます 。

- 動画生成 (Veo): テキスト記述から高品質な動画を生成する「Veo」モデルも利用可能になりつつあります 。

これにより、AIワークフロー内でコンテンツ作成、イラスト生成、データ可視化などをシームレスに行えます。

↓数秒でこのレベルの画像を生成できます。chatGPTやMidjerneyでの画像生成に比べると、かなり早い印象です

コード生成・実行・支援

開発者にとって強力な味方となる機能も豊富です。

- コード生成・補完: Python, JavaScript, Java, Goなど、様々なプログラミング言語のコードを生成したり、入力途中のコードを補完したりできます。

- コード実行 (Code Execution): モデルがPythonコードを生成し、それを実際に実行して計算、データ分析、グラフ描画などを行うことができます 。これにより、単なるコード生成にとどまらず、実行結果に基づいたより高度な問題解決が可能になります。

- コード支援 (Gemini Code Assist): VS CodeやJetBrains IDEなどの開発環境に統合され、リアルタイムでのコード補完、バグ修正提案、コード解説、テスト生成などを通じて開発プロセスを支援します 。

高度な機能:AIをより賢く、便利に

Gemini APIは、以下のような先進的な機能を提供し、より高度でインテリジェントなアプリケーション開発を可能にします。

- 長文コンテキストウィンドウ (Long Context Window): 前述の通り、最大100万トークン(Gemini Advancedでは最大1500ページのテキストや3万行のコードに相当)という巨大な入力処理能力を持ちます 。これにより、書籍全体、大規模なコードリポジトリ、長時間の動画などを丸ごと読み込ませ、深いレベルでの理解、分析、要約が可能になります。

- Function Calling (関数呼び出し): モデルが外部のAPIやツールと対話し、リアルタイムの情報を取得したり、特定の操作(例: メール送信、カレンダー登録)を実行したりすることを可能にする機能です 。これにより、AIが単なる情報提供者ではなく、具体的なタスクを実行するエージェントとして機能します。

- Grounding (グラウンディング): Google検索やVertex AI Searchのデータストアと連携し、モデルの応答を最新のウェブ情報や独自のデータソースに基づいて補強し、事実に基づいた正確性と信頼性を向上させる機能です 。

- Thinking Mode (思考モード): Gemini 2.5 Pro/Flashなどのモデルに搭載されており、応答生成前に内部的に推論ステップ(思考プロセス)を経ることで、複雑な問題に対するパフォーマンスと精度を向上させます 。

- 構造化出力 (Structured Output): モデルの出力をJSONのような特定の構造化データ形式に制約する機能です 。APIの応答を他のシステムで自動処理しやすくします。

- キャッシュ (Caching): ユーザーの入力とモデルの出力をキャッシュすることで、同じようなリクエストに対する応答時間を短縮し、コストを削減する機能です。

これらの高度な機能、特にFunction Calling、Code Execution、Grounding、Thinking Modeは、Geminiが単なるテキスト/画像生成ツールを超え、計画を立て、ツールを使いこなし、タスクを実行し、応答前に熟考する「AIエージェント」としての能力を獲得しつつあることを示しています。

オンデバイスAI (Gemini Nano)

Gemini Nanoは、AIモデルをユーザーのデバイス(Android端末やChromeブラウザ搭載PCなど)上で直接実行可能にします 。Google AI Edgeプラットフォーム を通じて提供され、以下のようなメリットがあります。

- 低レイテンシ: クラウド通信遅延がなく応答が速い。

- オフライン機能: ネット接続なしで利用可能。

- プライバシー向上: データがデバイス外に出ない。

- コスト効率: クラウドAPI利用料を削減できる可能性。

スマートリプライ、テキスト要約、校正などのタスクに適しています 。

具体的な活用事例紹介

これらの機能を組み合わせることで、以下のような多様なアプリケーションが実現可能です。

- インテリジェントなチャットボット・仮想アシスタント: 複雑な質問に答え、外部情報を参照し、ユーザーの代わりにタスクを実行する。

- 高度なコンテンツ作成支援: リサーチから構成案作成、執筆、画像生成までを一気通貫で行う。

- データ分析とレポート生成: 大量のデータ(CSV、スプレッドシート、PDFなど)を読み込み、分析し、洞察を抽出し、可視化(グラフ生成)まで行う 。

- コード開発支援・自動化: コード生成、デバッグ、リファクタリング、ドキュメント作成などを自動化。

- マルチモーダル検索・分析: 画像、動画、音声を含む多様なデータソースから関連情報を検索・分析する。

- 業務プロセス自動化: Function Callingなどを活用し、定型業務やワークフローを自動化する。

- 教育・学習支援: 大量の教材を読み込み、質疑応答や要約、個別学習プランの作成などを行う。

- クリエイティブ制作支援: ストーリー生成からイラスト・動画生成までをサポート。

3. Gemini APIの使い方 - 導入から開発まで

Gemini APIを使ってみたいと思ったら、どのように始めればよいのでしょうか?アクセス方法の選択から、具体的な開発手順、セキュリティの注意点まで解説します。

アクセス方法の選択:Google AI Studio vs Vertex AI

Gemini APIを利用するには、主に2つのプラットフォームがあります。どちらを選ぶかは、プロジェクトの目的や要件によって異なります。

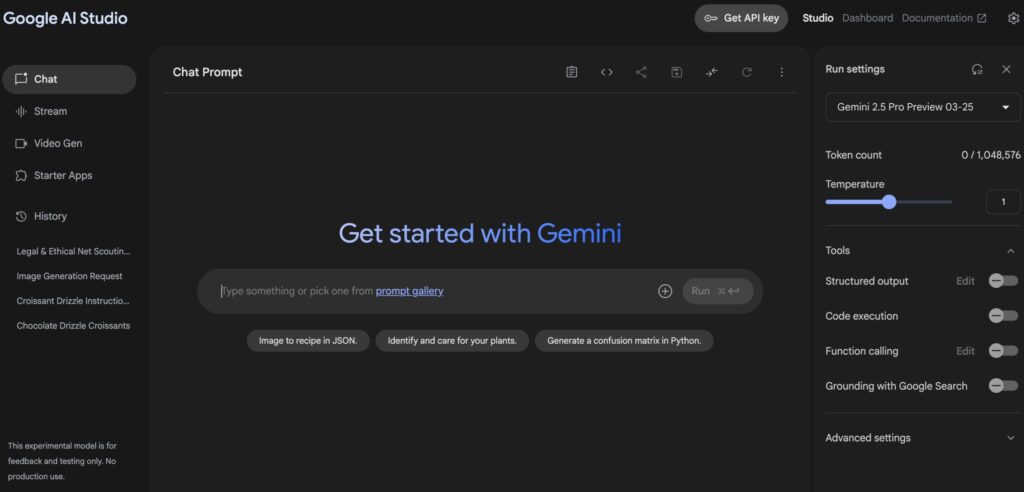

- Google AI Studio:

- 特徴: ウェブベースのUIで手軽にモデルを試したり、プロンプトを開発したりできるプラットフォーム。迅速にAPIキーを取得でき、無料枠が用意されています 。

- メリット: セットアップが簡単、すぐに試せる、無料枠がある。

- デメリット: 機能制限(MLOpsツールなどがない)、エンタープライズレベルのセキュリティ機能が限定的、APIキー認証のため本番環境のクライアントアプリからの直接利用は非推奨。

- おすすめの用途: プロトタイピング、学習、個人的な実験。

- Vertex AI (Google Cloud):

- 特徴: Google Cloudの統合AIプラットフォーム 。Geminiモデルへのアクセスに加え、MLOpsツール(モデル管理、監視、パイプライン自動化など)、エンタープライズレベルのセキュリティ(IAM、VPC Service Controls 、データ所在地管理、顧客管理の暗号鍵 (CMEK) )、スケーラビリティ、他のGoogle Cloudサービスとの連携機能を提供します。

- メリット: 本番環境向けの堅牢な機能、高度なセキュリティとガバナンス、スケーラビリティ、MLOpsによる効率的な運用。

- デメリット: セットアップがAI Studioより複雑、基本的に従量課金(ただし無料トライアル/クレジットあり )。

- おすすめの用途: 本番アプリケーション、エンタープライズ利用、高度なセキュリティやスケーラビリティ、MLOpsが必要な場合。

表2: Google AI Studio と Vertex AI のアクセス比較

| 比較項目 | Google AI Studio | Vertex AI (Google Cloud) |

| 主な用途 | プロトタイピング、学習、実験 | 本番アプリケーション、エンタープライズ利用、MLOps |

| 認証方法 | APIキー | Google Cloud 認証 (サービスアカウント推奨) |

| 料金モデル | 無料枠あり (制限付き) | Google Cloud の従量課金 (無料トライアル/クレジット適用可能) |

| セキュリティ機能 | 基本的なAPIキー管理 | IAM, VPC Service Controls, CMEK, データ所在地管理, App Check連携など |

| MLOps機能 | 限定的 | Vertex AI Pipelines, Model Registry, Monitoring 等の統合MLOps機能 |

| セットアップ複雑度 | 低 | 中 |

重要な注意点 (セキュリティ): Google AI StudioのAPIキーは手軽ですが、クライアントサイド(Webブラウザやモバイルアプリ)のコードに直接埋め込むのは非常に危険です。悪意のある第三者にキーを盗まれ、不正利用されるリスクがあります。本番のクライアントアプリでは、Vertex AI (特にFirebase SDKとの連携 ) を利用するか、APIキーを使う場合でも安全なバックエンドサーバー経由でAPIを呼び出すアーキテクチャを強く推奨します。

導入手順

- Googleアカウントの準備: いずれのプラットフォームを利用する場合も、Googleアカウントが必要です。

- プラットフォームの選択と設定:

- Google AI Studioの場合:

- (https://aistudio.google.com/) にアクセスし、Googleアカウントでログインします。

- 「APIキーを取得」または類似のボタンをクリックしてAPIキーを生成します。生成されたキーは安全な場所に保管してください。

- Vertex AIの場合:

- Google Cloud Console にアクセスし、Googleアカウントでログインします。

- Google Cloudプロジェクトを作成または選択します。

- プロジェクトで課金を有効にします(無料トライアル/クレジットが適用される場合があります)。

- 必要なAPI(例: Vertex AI API

aiplatform.googleapis.com, Generative Language APIgenerativelanguage.googleapis.com)を有効にします。 - 認証情報を作成します。サーバーサイドアプリケーションなどでは、APIキーよりも安全なサービスアカウントキーの利用が推奨されます。

- 必要に応じて、IAMロール(例: Vertex AI ユーザー)をユーザーまたはサービスアカウントに付与します。

- Google AI Studioの場合:

- 開発環境の準備:

- 利用したいプログラミング言語(Python, JavaScriptなど)の開発環境をセットアップします。

- 対応するGoogle Gen AI SDKをインストールします 。

開発方法

- 公式SDKの利用: Googleは主要言語向けに「Google Gen AI SDK」を提供しており、APIとの連携を簡素化します 。

- 対応言語 (例): Python , JavaScript/TypeScript , Go , Java , Swift , Dart (Flutter) , Android (Kotlin/Java) , Apps Script。

- これらのSDKは、ストリーミング、Function Calling、Code Execution、Grounding、メディア生成などの最新機能をサポートし、AI StudioとVertex AIの両方に接続可能です。

- REST API: SDKが提供されていない言語や、より直接的な制御が必要な場合は、HTTPリクエストでAPIエンドポイントを直接呼び出すことも可能です。

- 開発ツール:

- Google AI Studio / Vertex AI Studio: Web UI上でインタラクティブにプロンプトを試作・テストできます。

- IDE統合 (Gemini Code Assist): VS CodeやJetBrains IDE内でAIによるコーディング支援を受けられます 。

- Colaboratory (Colab): ブラウザベースのノートブック環境で、Python SDKを使ったチュートリアルや実験に便利です 。

簡単なコード例 (Python SDK - Google AI Studio向け)

Python

import google.generativeai as genai

import os

# APIキーを設定 (環境変数から読み込むことを推奨)

# Google AI Studioで取得したAPIキーを設定

# os.environ['GEMINI_API_KEY'] = 'YOUR_API_KEY' # ← 実際のキーに置き換えるか、環境変数に設定

genai.configure(api_key=os.environ['GEMINI_API_KEY'])

# 使用するモデルを選択 (例: Gemini 2.0 Flash)

model = genai.GenerativeModel('gemini-2.0-flash') # 最新モデルは公式ドキュメントで確認

# テキスト生成のリクエスト

prompt = "Gemini APIについて初心者向けに簡単に説明してください。"

response = model.generate_content(prompt)

# 結果の表示

print(response.text)

# マルチモーダル入力の例 (画像とテキスト)

# 画像ファイルをアップロード (別途ファイルAPIの利用が必要な場合あり [6])

# image_path = "path/to/your/image.jpg"

# image_file = genai.upload_file(path=image_path) # ファイルAPI利用例

# 画像とテキストで質問

# prompt_multi = [

# "この画像に写っているものは何ですか?",

# image_file

# ]

# response_multi = model.generate_content(prompt_multi)

# print(response_multi.text)

# ファイルを削除 (ファイルAPI利用時)

# genai.delete_file(image_file.name)

(注: 上記は基本的な例です。エラーハンドリングや高度な機能の利用には、公式ドキュメント やCookbookを参照してください。Vertex AIを利用する場合は、認証方法やSDKの初期化方法が異なります。)

セキュリティのベストプラクティス

- APIキーの厳重管理: Google AI StudioのAPIキーは絶対に公開リポジトリやクライアントコードに含めず、環境変数やシークレット管理ツールで保護してください。

- Vertex AI + サービスアカウント: 本番環境では、可能であればVertex AIとサービスアカウント認証を使用するのが最も安全です 。

- Firebase App Check: モバイル/Webアプリから直接APIを呼び出す場合(Vertex AI in Firebase SDK利用時)、App Checkで不正なクライアントからのアクセスをブロックします 。

- バックエンド経由: クライアントアプリからの呼び出しは、安全なバックエンドサーバーを経由するアーキテクチャを検討してください。

- 安全性設定: APIには不適切コンテンツをフィルタリングする安全設定があります。ユースケースに合わせて調整しましょう 。

- 責任あるAI: Googleが提供する責任あるAIのガイドラインに従い、倫理的な配慮を持って開発・運用しましょう。

4. Gemini APIの料金体系

Gemini APIの利用料金は、主に利用量に基づいて計算されますが、無料で試せる枠も用意されています。

(重要注意: 以下の料金情報は2025年4月時点の参考情報であり、変動する可能性があります。最新かつ正確な情報は、必ずGoogle AI Studioの料金ページ または Vertex AIの料金ページ で確認してください。)

料金モデルの基本

Gemini APIの料金は、以下の要素で決まります。

- 課金単位:

- トークン: テキストやコードの断片。入力と出力でカウントされます。1トークンは約4文字(英語の場合)に相当します。

- 文字数: Vertex AIの一部の旧モデルでは文字数課金の場合もありましたが、新しいモデルではトークン課金が主流です 。

- 画像/動画/音声: 画像1枚あたり、動画/音声1秒あたり、といった単位で課金される場合があります 。

- 入力 vs 出力: 一般的に、入力処理よりも出力生成の方が単価が高く設定されています 。

- モデルの種類: 高性能なモデル(Pro)ほど高価で、速度・コスト重視のモデル(Flash, Flash-Lite)は安価になる傾向があります 。

- コンテキスト長: 一部のモデルでは、一定以上のコンテキスト長(例: 128kトークン超)で単価が変わる場合があります 。

- 高度な機能:

- Thinking Mode: 思考プロセスに使われたトークンも出力トークンとして課金される場合があります 。

- Grounding: Google検索を利用したGroundingには、リクエスト回数に応じた追加料金が発生することがあります 。

- キャッシュ: キャッシュされたトークンやストレージ時間に対して課金される場合があります 。

- プラットフォーム:

- Google AI Studio: 無料枠を超えると従量課金 。

- Vertex AI: 基本的にGoogle Cloudの従量課金 。ただし、Vertex AIの方がエンタープライズ向けの機能やサポートが充実しています 。

無料枠とトライアル

- Google AI Studio 無料枠: 多くのモデルで、1分あたりのリクエスト数(RPM)や1日あたりのトークン数/リクエスト数に制限のある無料枠が提供されています 。プロトタイピングには十分な場合が多いです。

- 例: Gemini 1.5 Flash/Flash-8B/1.0 Pro は 15 RPM、Gemini 1.5 Pro は 2 RPM (2024年時点の情報 )。

- Google Cloud 無料トライアル/クレジット: 新規Google Cloudユーザーは、通常$300相当の無料クレジットが付与され、Vertex AIの利用料金に充当できます 。

- 特定プログラム: スタートアップや学生、研究者向けのクレジット提供プログラムが存在する場合もあります。

有料プランの料金例 (トークン課金、2025年4月時点の参考)

| モデル例 | 課金単位 (入力) | 入力価格 (USD/1Mトークン) | 課金単位 (出力) | 出力価格 (USD/1Mトークン) | 備考 (コンテキスト長など) |

| Gemini 2.5 Pro (Preview) | トークン | $1.25 (≤200k) / $2.50 (>200k) | トークン | $10.00 (≤200k) / $15.00 (>200k) | Thinkingトークン含む |

| Gemini 2.5 Flash (Preview) | トークン (Text/Image/Video) | $0.15 | トークン | $0.60 (Non-thinking) / $3.50 (Thinking) | Audio入力は$1.00 |

| Gemini 2.0 Flash | トークン (Text/Image/Video) | $0.10 | トークン | $0.40 | Audio入力は$0.70 |

| Gemini 2.0 Flash-Lite | トークン | $0.075 | トークン | $0.30 | 最も安価 |

| Gemini 1.5 Pro | トークン | $1.25 (≤128k) / $2.50 (>128k) | トークン | $5.00 (≤128k) / $10.00 (>128k) | 2024年10月価格改定 |

| Gemini 1.5 Flash | トークン | $0.075 (≤128k) / $0.15 (>128k) | トークン | $0.30 (≤128k) / $0.60 (>128k) | 2024年8月価格改定 |

| Gemini 1.5 Flash-8B | トークン | $0.0375 (≤128k) / $0.075 (>128k) | トークン | $0.15 (≤128k) / $0.30 (>128k) | 1.5 Flashより安価 |

| Imagen 3 (画像生成) | - | - | 画像あたり | (要確認) | - |

(再掲: 上記は参考情報です。必ず公式の料金ページ で最新情報を確認してください。Vertex AIではリージョンによって料金が異なる場合もあります 。)

クォータとレート制限

APIの安定性と公平性を保つため、利用量には上限(クォータ)が設けられています。

- レート制限 (RPM): 1分あたりのリクエスト数に上限があります。無料枠では低めに設定されていますが(例: 15 RPM )、有料プランやVertex AIではより高い制限が適用され、申請により引き上げも可能です 。

- 例: Gemini 1.5 Flash (有料) 2,000 RPM, Gemini 1.5 Pro (有料) 1,000 RPM (2024年9月時点 )

- トークン制限 (TPM): 1分あたりに処理できる合計トークン数にも制限がある場合があります 。

- その他のクォータ: 1日あたりのリクエスト数 や、ファイルAPIのストレージ容量などにも制限が設けられていることがあります。

アプリケーションが高負荷になる場合は、これらの制限を考慮し、エラーハンドリング(例: HTTP 429 Too Many Requestsに対する指数バックオフ)を実装し、必要に応じて事前にクォータ引き上げを申請することが重要です。

コスト削減のヒント

- 適切なモデル選択: タスクの要件を満たす最もコスト効率の良いモデルを選びましょう(例: 高頻度タスクにはFlashやFlash-Lite )。

- プロンプトの最適化: プロンプトを簡潔かつ明確にし、不要なトークンを削減します。

- キャッシュの活用: Context Caching機能 を利用して、繰り返し利用するプロンプト部分のコストとレイテンシを削減します。

- バッチ処理: 大量のリクエストはバッチ処理API 4 を利用するとコストを抑えられる場合があります。

- 思考予算の調整 (2.5 Flash): Thinking Modeを利用する際、タスクの複雑さに応じて思考予算(トークン数)を調整します 。

- 利用状況のモニタリング: Google Cloudコンソールの請求ダッシュボード やCloud Monitoring で利用状況を定期的に確認し、予算アラートを設定します 。

5. Gemini APIと他のAI API (例: OpenAI API) との比較

市場にはGemini API以外にも優れたAI APIが存在します。ここでは、代表的な競合であるOpenAI API (GPT-4oなど) やAnthropic API (Claude 3.7 Sonnetなど) と比較した場合のGemini APIの強みと考慮事項をまとめます。

Gemini APIの主な強み

- ネイティブなマルチモーダル性: 設計思想としてテキスト、画像、音声、動画などを統合的に扱える点が強みです。

- 圧倒的な長文コンテキスト: 最大100万〜200万トークンというコンテキストウィンドウは、現時点で他を大きく引き離しており、大規模な情報処理を可能にします 。これはGPT-4o (約128k) やClaude 3.7 Sonnet (200k) と比較して大きなアドバンテージです。

- Googleエコシステムとの統合: Google Cloud (Vertex AI), Firebase, Google検索, Workspaceなどとの連携は、既存のGoogleユーザーやエンタープライズ利用において大きなメリットです 。

- モデルの多様性と専門性: 高性能(Pro)、高速/低コスト(Flash)、オンデバイス(Nano)といった多様なニーズに応えるモデルラインナップを提供しています 。

- 先進的な独自機能: Thinking Mode , Code Execution , Grounding, Live API など、ユニークで強力な機能を提供しています。

- コスト競争力: 特にFlash系のモデルや、最近のProモデルの価格改定 により、特定のユースケースではOpenAIやAnthropicの同等モデルと比較してコスト効率が良い場合があります(ただし、料金体系は複雑なため要比較)。

- 例: Gemini 1.5 Pro (<128k) は入力$1.25/出力$5.00 、GPT-4o (最新版) は入力$2.50/出力$10.00 、Claude 3.7 Sonnetは入力$3.00/出力$15.00 。 (※価格は1Mトークンあたり、2025年4月時点参考)

考慮事項

- 複雑性: モデルの種類、アクセスプラットフォーム、SDK、機能が多く、選択肢が多い反面、学習コストがやや高い可能性があります。

- 機能の成熟度/利用可能性: 一部の最新モデルや機能は「Preview」や「Experimental」段階であり 、安定性や利用可能なリージョンに制限がある場合があります 。

- エコシステムへの依存: 高度な機能(特にセキュリティやMLOps)を最大限活用するには、Google Cloudエコシステムへの依存度が高まる可能性があります。

- ドキュメント: 情報量は豊富ですが、複数のプラットフォームやSDKにまたがる情報を整理して理解するには慣れが必要かもしれません。

どちらを選ぶべきか?

- Gemini APIが適しているケース:

- 非常に長いコンテキスト(大量の文書、コード、動画)を扱う必要がある。

- 画像、音声、動画を含むマルチモーダルな処理が重要。

- Google CloudやFirebaseを既に利用している、または連携させたい。

- Thinking ModeやCode Executionなどの高度な機能を利用したい。

- オンデバイスでのAI実行が必要。

- コスト効率を重視し、Flash系のモデルが要件に合う。

- 他のAPI (OpenAI, Anthropicなど) を検討するケース:

- 特定のベンチマークで最高性能が求められる(モデルによって得意不得意があるため比較が必要 )。

- よりシンプルなAPIインターフェースやドキュメントを好む。

- Googleエコシステムへの依存を避けたい。

- 特定の機能(例: OpenAIの特定のツール連携)が必要。

最終的な選択は、プロジェクトの具体的な要件、予算、開発チームのスキルセット、そして各APIの最新の性能と機能を比較検討して決定することが重要です。

Gemini APIが必要な人と、通常のGeminiで十分な人とは?

Gemini APIが必要な人と、通常のGemini(Webアプリやモバイルアプリなど)で十分な人との違いは、主にGeminiをどのように利用したいか、そして技術的なスキルがあるかどうかにあります。

Gemini APIが必要となる主なケース:

- 開発者・企業:

- 自分のアプリケーションやサービスにGeminiの機能を組み込みたい場合: 例えば、自社ウェブサイトにAIチャットボットを導入したり、コンテンツ生成ツールを開発したり、社内システムに要約機能を追加したりする場合です。

- 特定のワークフローを自動化したい場合: 大量のテキストデータを処理して分類・要約したり、定型的なレポートを自動生成したりするなど、プログラムを通じてGeminiを繰り返し利用したい場合。

- より高度な制御やカスタマイズが必要な場合: APIを通じて、モデルのパラメータ(例:temperature)を細かく調整したり、特定のタスクに最適化したりしたい場合。

- 大規模な処理を行いたい場合: 大量のデータを扱ったり、多くのユーザーにサービスを提供したりするために、スケーラブルなAI機能が必要な場合。

- 新しいAI搭載の製品やサービスを開発したい場合。

- 要するに: プログラミングによってGeminiモデルを直接操作し、他のシステムと連携させたり、独自のAIソリューションを構築したりする必要がある人。

通常のGeminiで十分な主なケース:

- 個人ユーザー・一般利用者:

- 日常的な疑問や質問への回答が欲しい場合: 検索エンジンのように、あるいはそれ以上に、対話形式で情報を得たい。

- 文章作成のサポートが欲しい場合: メール、ブログ記事、レポート、詩、コードなどの下書き、アイデア出し、校正、要約、翻訳などを手伝ってほしい。

- 学習や知識習得のツールとして使いたい場合: 複雑な概念を分かりやすく説明してもらったり、学習計画を立ててもらったりしたい。

- アイデア出しやブレインストーミングの相手が欲しい場合。

- プログラミング不要で、すぐにAIと対話したい場合。

- 要するに: Webインターフェースやアプリを通じて、直接Geminiと対話し、個人的なタスクや情報収集、創作活動などにAIを活用したい人。開発やシステム連携は不要。

- Gemini API: 開発者向け。自分のアプリやサービスにAIを組み込んだり、自動化したり、大規模に利用したり、細かく制御したりしたい場合に必要。プログラミング知識が前提。

- 通常のGemini: 一般ユーザー向け。プログラミング不要で、AIと直接対話して情報収集、文章作成支援、学習などに利用したい場合に十分。

ご自身の目的や技術スキルに合わせて、どちらが適しているか判断できます。

まとめ

Google Gemini APIは、最先端のマルチモーダルAIモデルファミリーへのアクセスを提供し、開発者に革新的なアプリケーションを構築するための強力なツールセットを与えてくれます。

Gemini APIの主な価値:

- テキスト、画像、音声、動画、コードをシームレスに扱えるネイティブなマルチモーダル性。

- 業界をリードする長文コンテキスト処理能力 (最大100万トークン超) 。

- 多様なモデルラインナップ (Pro, Flash, Nano) による柔軟な選択肢。

- 高度な機能 (Function Calling, Code Execution, Grounding, Thinking Modeなど) によるインテリジェントな処理 。

- Googleエコシステムとの強力な連携。

- オンデバイス実行の選択肢 (Nano) 。

導入に向けた推奨ステップ:

- 目的の明確化: プロトタイプか本番か? 必要な機能は? セキュリティ要件は? 予算は?

- プラットフォーム選択: まずはGoogle AI Studio で手軽に試し、本番開発や高度な要件がある場合はVertex AI への移行を検討する 。

- モデル選択: タスクの複雑さ、速度、コストに応じて最適なモデル (Pro, Flash, Nanoの各バージョン) を選択する 。

- 開発とテスト: 公式SDK とドキュメント、Cookbookを活用し、セキュリティに配慮しながら開発を進める。

- コスト管理: 料金体系を理解し 、利用状況を監視し 、コスト削減策を検討する。

- 情報収集の継続: Gemini APIは急速に進化しています。公式ブログ やドキュメント を定期的にチェックし、最新情報を把握しましょう。

Gemini APIは、あなたのアイデアを形にし、これまでにないAI体験を創造するための扉を開きます。ぜひこのガイドを参考に、Gemini APIの世界を探求してみてください。